筆者在上一篇「資料科學家的告白:給幼苗們的忠告」中談「人」的部分,本篇分享一下「物」。

在大數據思潮之下,以數據作為論證基礎的意識抬頭,各大企業紛紛尋求資料科學導入方案,急欲將長年累計的數據經驗加以分析,用來改善精進其營運流程,並以此為本規劃未來方針。

然而,資料科學的導入並非一朝一夕,透過幾場教育訓練或是採購一套完整解決方案就真的能解決。筆者從事多年的資料分析與資料科學導入經驗來說,資料科學的第一步是從具備分析性思維的資料共享開始。資料共享的概念不是新玩意,Google drive, Dropbox 就是眾所皆知的解決方案,然而這些產品強調的是檔案或是文件共享,並不真的是資料共享。我們認為好的資料共享平台需要事先完成資料預處理 (data pre-processing),讓資料分析師能夠立即實作,計算結果能在最短時間內產出。另一方面,介接已完成預處理的資料,針對企業營運的重要目標以動態儀表板的方式做呈現,讓量化指標能夠立即反映企業營運的特徵與趨勢。

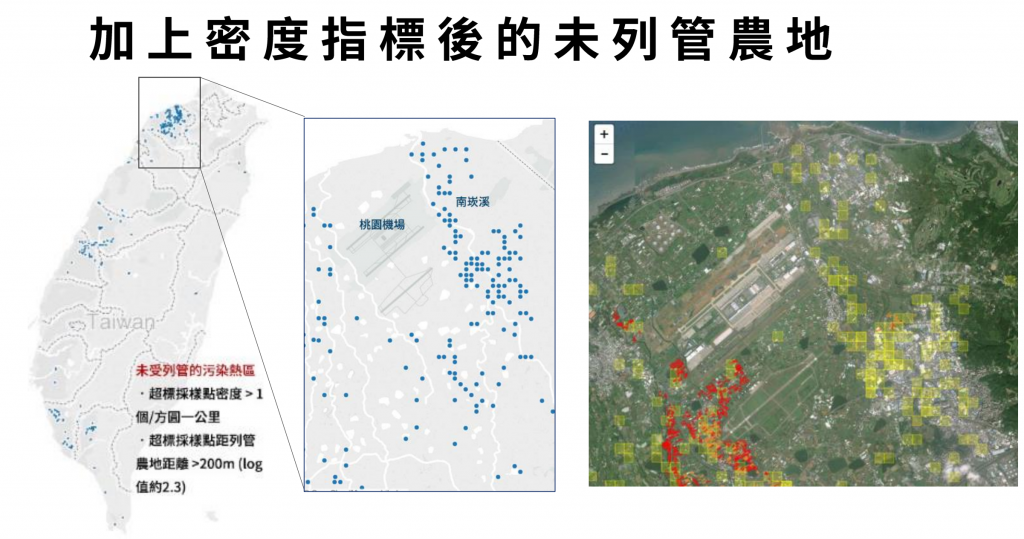

資料共享平台不只是檔案共享,更要能幫助企業營運。(圖片來源:http://data.dsp.im)

值得一提的是完成預處理的資料必然不是 docx, xlsx, pdf, jpg, png 等文件、影像格式,是能夠透過 API (application programming interface) 的介接轉換成 csv, json, xml 可直接應用於資料分析的格式。這種分析性思維的資料共享平台有幾個特點:

1. 全體員工的資料素養提升

資料科學的核心是「人」而不是「機器」。企業的營運特徵與趨勢經由資料共享平台以動態儀表板的方式傳遞給企業每一個層級的員工,完成預處理的資料讓大家可以輕易地介接使用有助於提升全員的資料素養。

日前跟一位遊戲產業的CEO跟我抱怨,要尋得同時具備領域經驗與資料素養的副手有多麼困難。深入瞭解後發現公司日常的營運報表只有少數幾位高層能夠看到,完整的報表彙整自業務、行銷、技術、客服…等不同部門,製作報表的同仁各自行事,雖有各自專業卻往往見樹不見林。

直到導入了這種資料共享方案,不僅同仁們願意以數據做為決策依據,更進一步強化員工跨部合作的意識。除此之外,讓這位CEO從中提拔了優秀人才。

2. 實務上適應性更高

分析性思維的資料共享機制具有高度適應性 (adaptive),而非預期性 (predictive)。資料科學流程可概分為四個主要步驟:定義目標、資料盤點、資料分析、行動決策。所謂的預期性係指整體流程是穩健可預期的,需求項目相對固定,可以按部就班交辦完成。

實際進行資料分析專案時,穩定的因素其實很難滿足。傳統上的做法是在一個很長的時間跨度內對各個流程做詳細的規劃,盡可能降低不確定的因素。然而,我們往往需要在有限的時間內下決策,敏捷地在四個步驟間進行往返修正顯得極其重要。

分析性思維係指事先準備好一個資料湖泊 (data lake),這是一個匯聚眾多已完成預處理資料集的湖泊,水源可以是來自各部門的內部資料,可以是公司外部的開放資料,也可以是前一次完成分析報告後的重要指標。使用者可以在裡面對資料集做快篩,找出能解決問題的潛在資料集,快速導入資料分析。這樣的機制不僅能夠適應實務上充滿不確定性的狀況,甚至是歡迎變化,透過多次的迭代循環確立更佳的資料科學解決方案。

3. 進階拓展更容易

對於資料分析目標明確有系統化需求的企業,可以透過 API 向資料湖泊介接資料,從事各種應用服務。其好處在於資料 (核心) 與服務 (外殼) 能夠明確切割,便於資料權限控管以及服務的版本更新。

分析性思維的資料共享平台三個特點:資料儀表板提升資料素養、資料湖泊提升分析的適應性、API實現進階應用。(圖片來源:http://eva.dsp.im)

現在就開始

我常將資料比喻成食材,資料科學家比喻成廚師,好的資料科學解決方案是秀色可餐且營養兼具的佳餚。正在尋求資料科學解決方案的企業主們,你們要的只是大數據小數據結構化數據非結構化數據都能儲存的「超級冰櫃」,還是能更進一步在煮飯前就先備好料的「智慧冰箱」呢?

近期迴響